iSCSI, GFS를 이용한 Multipath 구성

간략히 메모만..

#yum -y update

1. iscsi-initiator-utils가 설치되어 있는지 확인한다.

rpm -qa | grep iscsi

2. 설치되어 있지 않으면 설치한다.

yum -y install iscsi*

3. 초기자의 IQN을 확인한다.

cat /etc/iscsi/initiatorname.iscsi

4. 타겟 IQN, 초기자 IQN, 디스크 등을 맵핑시켜준다.

5. 타겟을 탐색한다.

iscsiadm -m discovery -t sendtargets -p 10.10.10.10

※ 타겟 제거 방법

iscsiadm -m node -T iqn.2003-10.com.lefthandnetworks:diotek-backup:80:vol04 -p 118.216.243.6 -u

6. 타겟에 로그인한다.

iscsiadm -m node -p 10.10.10.10:3260 -T iqn.2003-10.com.lefthandnetworks:diotek-backup:132:vol04 --login

7. fdisk -l 해서 추가된 디스크를 확인한 후

(여기서는 /dev/sdb 라는 놈이 확인)

8. fdisk로 파티셔닝 작업을 한다.

(파티션을 나누지 않고 통으로 사용한다고 가정)

fdisk /dev/sdb => n => p => 1 => Enter => Enter => w

------------- 생략 -----------------

9. ext3 파일시스템으로 포맷한다.

mkfs.ext3 /dev/sdb1

10. 마운트할 디렉터리를 생성하고 마운트한다.

mkdir /data

mount /dev/sdb1 /data

11. /etc/fstab 파일을 열어서 등록해준다.

/dev/sdb1 /data ext3 _netdev 0 0

--------------------------------------

selinux 는 종료

방화벽은 내린다

>>>주의 사항

1. /etc/hosts 안에는 두 노드간 통신할 수 있는 ip가 사설로 되어 있어야 하며, 이 ip를 gigabit으로 연결되는 구성이어야 한다.

/etc/hosts 내에

192.168.255.4 vm1.test.com

192.168.255.5 vm2.test.com

위와 같은 형태 이어야 하며,

127.0.0.1 구문은 luci Start를 위해서 필요하므로 주석 처리를 하면 안된다

2.두 노드에서 /etc/sysconfig/network 에는 hostname이 fqdn으로 vm1.test.co.kr 과 같이 설정되어 있어야 한다.

3. acpid는 off되어 있어야 한다.

방화벽을 내린다

#yum -y install gcc

#yum -y install luci

#yum -y install ricci

#yum -y install httpd

#yum -y groupinstall "Cluster Storage"

#yum -y groupinstall "Clustering"

#yum groupinstall "High Availability" "High Availability Management" -y

각 서비스를 시작한다

ricci 계정에 패스워드를 부여한다

웹 UI 에서 클러스터를 생성한다

Locking 타입 변경

># vi /etc/lvm/lvm.conf

...

locking_type = 3

lvmconf --enable-cluster

corosync-cfgtool -s

서비스 시작

service ricci start

service httpd start

lvmconf --enable-cluster

1. 파티션 나눈 후

partprobe /dev/sdb1

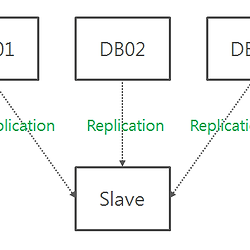

1. gfs로 쓸 파티션을 lvm으로 만든다. (공유 스토리지가 /dev/sda일 경우, 이 디스크는 node1과 node2에서 동시에 보여야 한다.)

pvcreate /dev/sdb1

# 2번째 노드 서버에서는 pvcreate /dev/sda1 -ff 옵션을 넣어줘야 한다

vgcreate VolGroupGFS /dev/sdb1

lvcreate -L 2G -n GFS VolGroupGFS

pvscan

vgscan

2. gfs 파티션으로 포맷 (혹시 몰라서 저널은 2개로 넣었다. 이 값은 gfs의 node 개수를 의미한다.)

mkfs.gfs2 -p lock_dlm -t Li:GFS -j 3 /dev/VolGroupGFS/GFS

mkfs.gfs2 -p lock_dlm -t LinuxCluster:GFS -j 3 /dev/VolGroupGFS/GFS

3. Restart iscsi on all nodeXXX

service iscsi restart (필요 없음)

4. Mount the volume on all nodeXXX

># mkdir /data

># mount /dev/VolGroupGFS/GFS /data

>>>서비스의 시작과 설정

양쪽노드에서 서비스를 하나씩 실행해서 마운트 한다.

service cman start

service clvmd start

service gfs2 restart (필요 없음)

chkconfig cman on

chkconfig clvmd on

chkconfig gfs2 on

chkconfig acpid off

3. gfs 파티션을 마운트 (선수 조건 : cman 데몬이 돌아간 상황이어야 한다)

mount -t gfs2 -o upgrade /dev/VolGroupGFS/GFS /data

4. /etc/fstab 에 마운트정보 삽입

/dev/volGFS/lvol0 /mnt/gfs gfs2 defaults 0 0

>>>서비스의 확인

[root@VM1 mnt]# cman_tool nodes

Node Sts Inc Joined Name

1 M 12 2009-10-19 20:17:01 vm1.test.co.kr

2 M 16 2009-10-19 20:17:01 vm2.test.co.kr

[root@VM1 mnt]# cman_tool status

Version: 6.2.0

Config Version: 5

Cluster Name: cluster112

Cluster Id: 41720

Cluster Member: Yes

Cluster Generation: 16

Membership state: Cluster-Member

Nodes: 2

Expected votes: 1

Total votes: 2

Quorum: 1

Active subsystems: 8

Flags: 2node Dirty

Ports Bound: 0 11

Node name: vm1.test.co.kr

Node ID: 1

Multicast addresses: 239.192.162.155

Node addresses: 192.168.0.192

- GFS 관련

#clustat

#cman_tool services

- 클러스터 관련

service clvmd status

- 파티션 관련

#blkid

스냅샷 2번 서버

iscsiadm -m node -T iqn.2003-10.com.lefthandnetworks:lhn-infraware-vg:164:linuxtest4 -p 61.96.206.153 -u

http://gihwan.tistory.com/9

http://kenshin579.tistory.com/25

http://www.centos.org/docs/5/pdf/Global_File_System.pdf

http://cafe.daum.net/redhat/CmUl/51?docid=1HjQ8CmUl5120091121112324